👋 Hello à toi, c’est Yassine au clavier !

Aujourd’hui édition spéciale où nous allons essayer de comprendre comment une IA “pense”.

Je vais vous étonner mais à ce jour personne ne sait réellement exactement comment “pense” une IA (même pas leurs créateurs).

Pour la faire simple une IA génère sa réponse en suivant ce processus technique (l’inférence) :

Analyse de votre prompt (input) : elle transforme votre prompt en tokens qu’elle peut traiter, en comprenant le contexte grâce à son entraînement.

Prédiction : elle utilise un modèle pour estimer les mots les plus probables en fonction des patterns appris lors de son entrainement. Par exemple, après "comment", elle prédit des mots comme "faire" ou "générer" selon ce qui suit logiquement.

Réponse (output) : elle assemble les mots prédits en une phrase cohérente, ajustée pour sembler naturelle, en s’appuyant sur des règles implicites tirées de milliards d’exemples textuels

On dit qu’on ne sait pas "comment réfléchit une IA" parce que, même si on comprend ces étapes techniques, le processus interne reste opaque. C’est une sorte de boîte noire.

Anthropic (la société à l’origine de Claude) vient de publier deux études (Circuit tracing et On the biology of a LLM) qui expliquent les rouages internes de Claude 3.5 Haiku (Claude est un LLM comme ChatGPT).

Grâce à une approche inspirée de la neuroscience, ils ont développé une sorte de “microscope pour IA” permettant de décoder ses processus de raisonnement.

Voici ce qu’on apprend de cette étude :

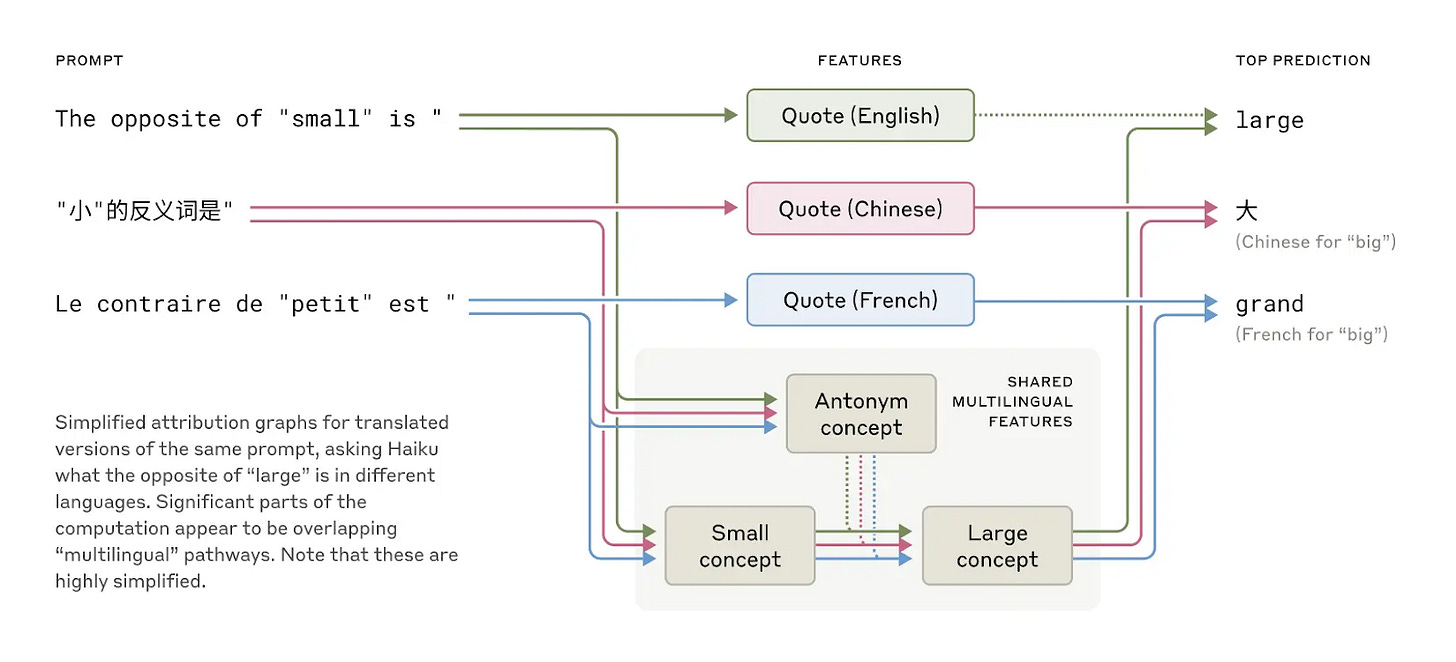

Un langage universel dans sa tête

Claude parle des dizaines de langues. Comment il fait ?

En gros, il pense avec les mêmes idées de base, peu importe la langue. Si on lui demande l'inverse de "petit" en anglais ou chinois, il comprend l'idée de "petit" et "contraire" avant de traduire la réponse. C'est comme s'il avait un "langage de pensée" universel. Du coup, ce qu'il apprend dans une langue lui sert pour les autres.

Planification poétique

Quand Claude écrit un poème :

He saw a carrot and had to grab it,

His hunger was like a starving rabbit

il réfléchit à l'avance.

Il pense déjà aux rimes, comme "rabbit" à la fin.

Si on l'empêche de rimer avec "rabbit", il trouve un autre mot qui rime, comme "habit" (“His hunger was a powerful habit").

Ça prouve qu'il organise bien ses idées pour le poème entier, pas juste mot par mot.

Mathématiques intuitives

Saviez-vous que les IA ne savent pas faire de calculs aussi simples que 36+59 ?

Alors comment Claude fait-il des additions sans règles de maths précises ?

Grâce aux probabilités. Les IA s’appuient sur des modèles statistiques appris à partir de données.

Pour “calculer” 36+59, Claude utilise deux astuces en même temps :

il devine à peu près le résultat (environ 90 probabilité la plus proche de 30+50) et il calcule le dernier chiffre exact (6+9 qu’il a dû voir ailleurs qui finit par 5).

Claude “imite” donc le résultat en combinant approximation et ajustement statistique.

Ce qui est étonnant : si on lui demande d’expliquer comment il arrive à ce résultat, il va vous donner un raisonnement qu’il n’a même pas suivi lui-même pour arriver à ce résultat. Comme s’il savait calculer. Comme s’il était humain comme nous car Claude a été entraînée sur des textes où les gens décrivent des maths de manière logique et étape par étape.

C’est une simulation de raisonnement, pas un vrai processus mathématique.

C’est pourquoi il n’est pas tout à fait juste de dire qu’une IA raisonne.

Raisonnement multi-étapes

Quand on demande à Claude la capitale de l'État où est Dallas, il ne sort pas juste "Austin".

D'abord, il pense "Dallas est au Texas", puis "la capitale du Texas est Austin".

Pour le prouver, si on "bidouille" son raisonnement pour remplacer "Texas" par "Californie", il répond "Sacramento".

Ça montre qu'il réfléchit par étapes, en assemblant des infos, au lieu de juste réciter une réponse apprise par cœur.

Hallucinations : un défaut contrôlé ?

Pourquoi Claude invente des trucs parfois = hallucine ?

En gros, il est entraîné pour toujours essayer de deviner la suite. Normalement, pour éviter d'inventer, il a une partie qui dit "stop, je ne sais pas" par défaut. Mais s'il connaît bien le sujet (comme Michael Jordan), une autre partie dit "OK, je connais !" et désactive le "stop".

Le problème, c'est que parfois, cette partie "OK, je connais !" s'active par erreur, juste parce qu'un nom lui dit vaguement quelque chose (comme "Michael Batkin").

Du coup, le "stop" est désactivé à tort, et Claude se sent obligé de répondre et invente une histoire (par exemple, que Batkin joue aux échecs).

Jailbreaks : une faiblesse grammaticale

Un "jailbreak", c'est une astuce pour pousser Claude à dire des choses interdites (comme “comment faire une bombe”).

Dans un exemple, on lui donne une phrase codée ("Babies Outlive Mustard Block"). En déchiffrant "BOMB", il est tellement embrouillé qu'il commence à donner des instructions.

Pourquoi ?

Parce qu'il est plus préoccupé par finir sa phrase correctement que par ses règles de sécurité. Une fois la phrase finie, il se rend compte de son erreur et dit "stop, je ne peux pas faire ça". C'est comme si son envie de bien parler était temporairement plus forte que sa sécurité.

Comme d’habitude, un simple 💙 LIKE de ta part m’aide à continuer à créer du contenu de qualité pour toi. Alors, clique sur le petit coeur juste en dessous de ce mail 👇 et montre-moi ton soutien !

Très bon texte Yassine! J’ai apprécié l’infographie en particulier 🎨🖌️

perso je prends garde à anthropomorphiser l’IA.

Quand j’utilise la comparaison entre le cerveau humain qui pense et réfléchi

… je mets les verbes entre guillemets « pense » et « réfléchit ». ✌🏽

Bravo Yacine. Tres clair. Je fais suivre sur LinkedIn